| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- 지연연산

- 하둡1.0

- 데이터베이스복사

- 하둡2.0

- 하둡

- AWS Crawler

- Spark

- 데이터파이프라인

- 하둡에코시스템

- Spark 최적화

- 빌드도구

- 카프카

- 프로그래머스

- 서버간 복사

- Catalyst Optimizer

- 데이터 수집

- 데이터엔지니어링

- 스파크

- 실행엔진

- 프로그래머스힙

- 런타임데이터영역

- 프로그래머스 큰 수 만들기

- 문맥교환

- ORACLE MSSQL차이

- freenom

- ORACLE문법

- kafka 설치

- Databricks

- lazy evaluation

- EMR 구조

- Today

- Total

띵유로그

[데이터파이프라인] Logstash 구성 및 twitter 연결 본문

wget 명령어를 통해 logstash 를 다운로드 받습니다.

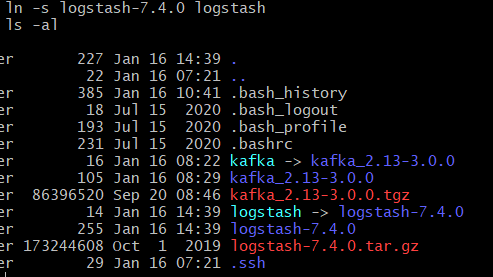

logstash 도 링크를 걸어줍니다.

그 후에 .bash_profile을 수정해서 어떤 경로에서도 logstash 명령어를 수행할 수 있도록 경로를 잡아줍니다.

그 후 수정된 값을 적용시키기 위해 source명령어를 실행해줍니다.

2. twitter 연동

먼저 트위터 계정을 만들고 개발자 app 신청을 합니다.

트위터 개발자 계정 신청하기

트위터의 API를 이용하기 위해서는 Access Token을 발급받아야 하는데, 그것을 위해 가장 기본적인 작업이 트위터 개발자 계정을 신청하는 일입니다. 개발자 계정만 신청해서 승인이 나면 Twitter Manag

www.citopes.com

그 후에 consermer_key, oauth_token을 발급받습니다.

producer 폴더를 하나 생성 한 후에 producer_test.conf파일을 만들어 정보를 입력합니다.

input {

twitter {

consumer_key => "~"

consumer_secret => "~"

oauth_token => "~"

oauth_token_secret => "~"

keywords => ["news","game","bigdata","nft"]

full_tweet => true

}

}

output{

stdout{

codec => rubydebug

}

}keywords를 트위터에서 수집했고 정상 작동하는지 확인하기 위해 우선 output 형식이 stdout로 지정해서 콘솔에 뿌려줍니다.

아래 명령어를 통해 logstash를 실행합니다.

아래와 같이 수집되는것을 볼 수 있습니다.

정상동작하는것을 확인했으니 이제 카프카 서버로 보내도록 하겠습니다.

3. 카프카 브로커로 보내기

좀전에 생성했던 conf 파일에서 output 부분만 수정합니다.

stdout으로 되어있던 것을 kafka로 수정해줍니다.

kafka {

bootstrap_servers => "카프카브로커 ip주소:9092"

codec => json{}

acks => "1"

topic_id => "토픽명"

}다시 logstash를 실행해서 프로듀서를 실행 한 후 컨슈머를 확인하면 잘 수집되는것을 볼 수 있다.

참고) consumer도 logstash로 구현했고, consumer.conf는 다음과 같다. (콘솔에 출력)

input {

kafka {

bootstrap_servers => "브로커id:9092"

topics => ["토픽명"]

consumer_threads => 1

decorate_events => true

}

}

output {

stdout {

codec=> rubydebug

}

}'DataEngineering' 카테고리의 다른 글

| [데이터 분석 파이프라인] EMR 구조와 실행 (0) | 2022.02.12 |

|---|---|

| [데이터파이프라인-2] Api gateway, Kinesis 테스트 (0) | 2022.02.06 |

| [데이터 파이프라인-2] Kinesis 구성하기 (0) | 2022.01.29 |

| [데이터파이프라인 - 2]AWS API Gateway 구성하기 (0) | 2022.01.29 |

| [데이터파이프라인]kafka 설치 ~ 토픽생성 (0) | 2022.01.16 |